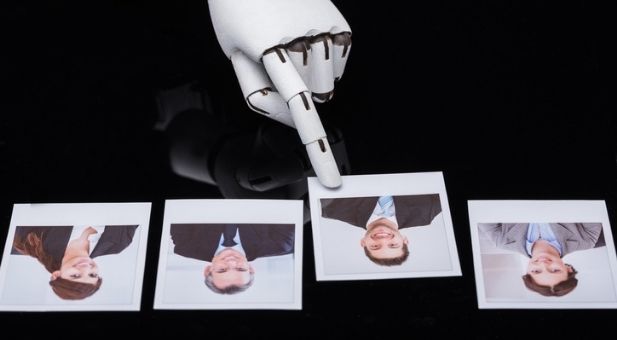

Recruiting, i rischi dell’intelligenza artificiale

Nel 2019, secondo un’indagine dell’associazione italiana per la direzione del personale (Aidp), il 58% dei manager delle risorse umane in Italia aveva introdotto negli ultimi tre anni sistemi digitalizzati e automatizzati nei processi di reclutamento e selezione del personale. Oltre il 60% degli intervistati aveva utilizzato questi sistemi nelle attività di pre-screening: il 45% vi aveva fatto ricorso per effettuare un’analisi automatizzata dei curriculum, il 27% per realizzare un’analisi motivazionale attraverso un controllo dei social network, il 25% per condurre interviste virtuali e il 19% per avere un’analisi semantica dei curriculum. Il ricorso a questo genere di strumenti è dettato soprattutto dai vantaggi offerti in termini di risparmio di tempo e riduzione dei costi: la ricerca Global Recruting Trends, realizzata da LinkedIn, ha a tal proposito evidenziato che per la stragrande maggioranza dei professionisti delle risorse umane (67%) il vantaggio principale dell’intelligenza artificiale è dato proprio dal risparmio di tempo (67%), seguito dal risparmio di risorse economiche (31%).

Tutto bene, dunque? Assolutamente no, perché ai vantaggi si associano anche dei rischi. Nel 2018, per esempio, uno scoop della Reuters rivelò che il sistema di machine learning utilizzato da Amazon nella ricerca del personale tendeva a discriminare le donne.

Il rischio di bias

L’algoritmo di Amazon era rimasto vittima di quello che in gergo tecnico si definisce “un bias dell’intelligenza artificiale”. Si tratterebbe di una sorta di pregiudizio insito nel sistema, che può generare risultati inaffidabili, parziali e potenzialmente pericolosi: svantaggiare le donne nella selezione del personale, come avvenuto nel caso dell’algoritmo di Amazon, costituisce il classico esempio di un bias dell’intelligenza artificiale.

Episodi di questo genere, con la progressiva diffusione della tecnologia, sono diventati sempre più numerosi. All’inizio dell’anno, per esempio, ha fatto grande scalpore il risultato di un esperimento in cui veniva chiesto a due algoritmi di intelligenza artificiale di completare l’immagine di una persona partendo unicamente da una foto del volto. Ebbene, sotto alla faccia di un uomo, gli algoritmi in esame, almeno nel 43% dei casi, avevano disegnato un completo elegante: messi invece di fronte al volto di una donna, i due sistemi nella maggior parte dei casi completavano l’immagine con un bikini o un top scollato. I ricercatori avevano spiegato che gli algoritmi avevano seguito un processo di apprendimento senza supervisione: erano dunque stati messi di fronte a un enorme database di immagini e, senza alcun intervento umano, avevano imparato autonomamente a classificare e distinguere i diversi soggetti delle foto. Il problema è che, a quanto pare, quel database era pieno di foto con donne in bikini. E i due algoritmi sono arrivati a concludere che le donne si vestono solitamente così.

Bias nella selezione del personale

Esiti di questo tipo, come già accennato, si sono avuti anche con algoritmi di intelligenza artificiale specializzati nella selezione del personale. Alcuni anni fa, tanto per citare un altro caso famoso, era venuto fuori che l’algoritmo di raccomandazione di LinkedIn, una delle principali piattaforme globali per la ricerca di lavoro, tendeva a privilegiare gli uomini. E ciò semplicemente in ragione del fatto che gli uomini sono solitamente più aggressivi nella ricerca di nuove opportunità lavorative, presentando la propria candidatura anche per posizioni per cui non dispongono completamente dei requisiti minimi richiesti.

Gli analisti, seppur in assenza di dati precisi, stimano che l’utilizzo di questo genere di soluzioni sia aumentato negli ultimi anni. Le misure di distanziamento sociale imposte con il coronavirus avrebbero inoltre impresso la spinta decisiva a strumenti per colloqui a distanza o dispositivi per l’analisi automatizzata dei curriculum. Il problema è che la presenza di bias non è ancora stata risolta, generando il rischio di nuove discriminazioni. La mancanza di trasparenza delle imprese di settore, dettata da ragioni commerciali, non facilita inoltre la gestione di processi tanto delicati per imprese e candidati: finché non verrà detto chiaramente come funzionano questi sistemi, sarà difficile garantire l’assenza di qualsiasi tipo di discriminazione.